誰能替代英偉達?

©產業象限原創

作者丨山茶

2月22日,英偉達發佈2024財年四季報,營收221億美元,同比增長265%,淨利潤123億美元,同比激增769%,雙雙大超市場預期。

然後,英偉達就殺瘋了。

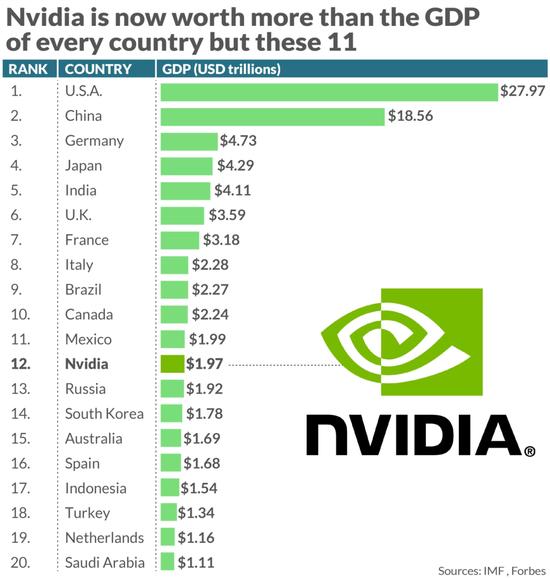

一夜之間,英偉達市值暴漲2770億美元,創下華爾街單日最大漲幅的歷史記錄。如今,英偉達的市值已經逼近2萬億美元。以國內生產總值計算,英偉達市值超過了大多數其他國家經濟體的規模。

▲圖源:福布斯

從企業層面看,這一市值也超越Meta,成爲僅次於微軟、蘋果和沙特阿美的全球第四大市值的巨無霸。

但有意思的現象是,雖然已經躋身第一梯隊,但無論是營收還是利潤,英偉達都與微軟、蘋果、甚至被它超過的Meta差距較遠。

可以對比來看:

-

微軟2024財年Q2營收620.2億美元,淨利潤218.7億美元;

-

蘋果2024財年Q1營收1195億美元,淨利潤339.16億美元;

-

Meta2023年Q4營收401億美元,淨利潤140.17億美元。

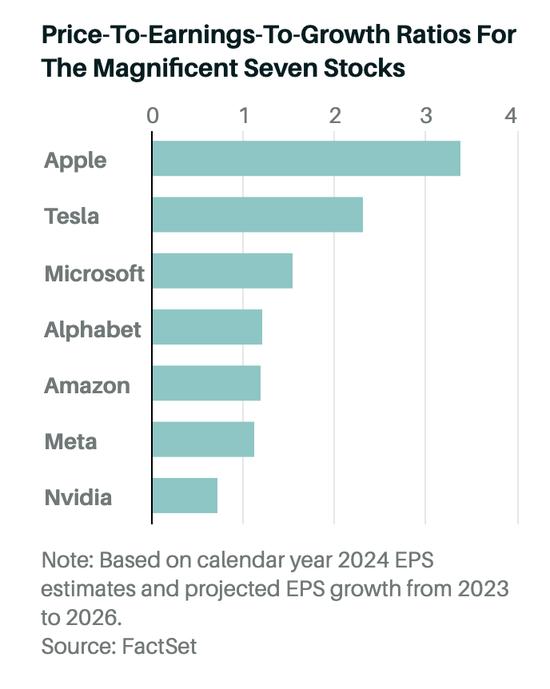

《巴倫週刊》使用基於FactSet預測的2023年至2026年預期平均盈利增長,以及基於2024年預測的市盈率,對美股7大巨頭企業的PEG比率(市盈率除以盈利增長率)也做了預測,英偉達是其中最低的。

▲圖源:FactSet

毫無疑問,如今英偉達的市值存在巨大泡沫,但從國內到國外,投資者卻都願意爲這樣的泡沫買單。

整個市場對英偉達充滿信心,因爲在某種程度上,市場已經將英偉達與AI時代的未來劃上了等號。

投資英偉達,就是投資屬於未來的AI時代,在這樣的邏輯下,英偉達似乎值得任何市值。

那麼,英偉達真的不可替代嗎?誰又會成爲英偉達的對手,誰又能將它趕下神壇?

01

英偉達,憑什麼遙遙領先?

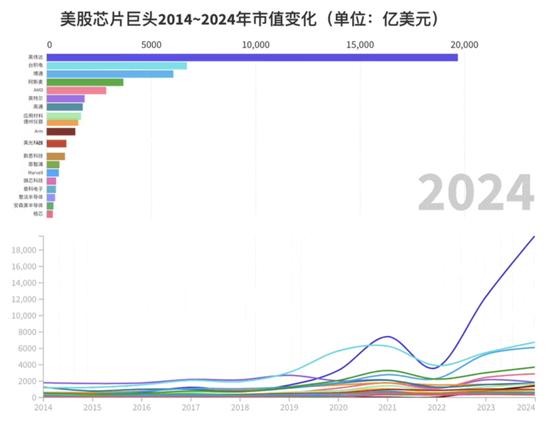

和其它半導體企業相比,英偉達是“遙遙領先”的,起碼在市值上如此。

如今,在全球前十的半導體企業中,不算臺積電和阿斯麥這樣的純代工廠和光刻機廠商,英偉達的市值約等於剩下七家市值的總和,甚至還有富餘。

▲圖源:芯東西

撐起英偉達市值的,是其全球領先的AI計算芯片,包括A100、H100和即將上市的H200。根據富國銀行的統計,英偉達目前在全球數據中心AI加速市場擁有98%的份額,處於絕對的統治地位。

很多時候,這些芯片花錢也都很難買到。早在2023年8月的時候,就有媒體報道,英偉達的訂單排到了2024年。其芯片的交付週期,也曾一度高達8~11個月(如今已經縮短爲3~4個月)。馬斯克曾爲此吐槽,“英偉達的芯片比毒品還難搞到”。

產能不足,供不應求,這些需求應該自然溢出到其他廠商。從供應鏈安全的角度考慮,面對如此集中的市場,企業似乎也不應該只選擇英偉達這一家的產品。

但全球的企業排着隊將訂單送到英偉達手中,難道,除了英偉達的芯片之外,AMD、英特爾這些企業的芯片都辦法訓練大模型嗎?

答案當然不是,但使用英偉達的芯片,目前仍然是訓練和運行大模型的最優選擇。這種優勢體現在四個方面,包括硬件性能、軟件生態、適用範圍和整體性價比。

首先是硬件性能。

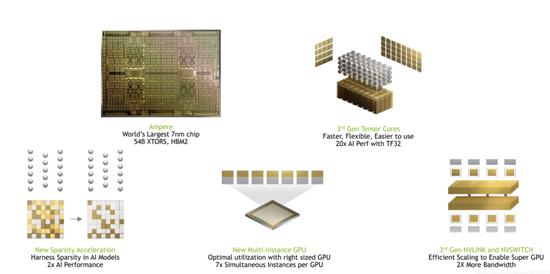

以英偉達在2020年5月發佈的NVIDIA A100 GPU爲例,這款芯片採用7nm製程和NVIDIA Ampere架構,擁有540億個晶體管和6912個CUDA核心,最高可以提供80GB的GPU顯存,以及2TB/s的全球超快顯存帶寬。在大模型訓練和推理常用的FP16(半精度浮點運算)Tensor Core峯值性能可以達到312TF,使用稀疏計算的情況下,可以達到624TF。

▲圖源:CSDN,NVIDIA GPU A100 Ampere(安培)架構深度解析

很多人對這些指標沒什麼概念,我們來簡單解釋一下。

芯片的製程決定着同樣大小的芯片能夠放下的晶體管的數量,而晶體管的數量越多,芯片的計算能力越強,這也是5納米的芯片一定比7納米的芯片先進的原因。

至於CUDA核心,即CUDA線程,是英偉達CUDA平臺編程模型中的基本執行單元。我們都知道,GPU最強的能力是並行計算,而CUDA核心越多,意味着芯片能同時並行計算的數量也就越多,芯片的性能更強,完成同樣任務的速度更快。

需要注意的是,芯片的計算能力強和計算效率高是兩個概念。製程和晶體管的數量代表着計算能力,而CUDA核心的數量,代表着計算效率。

至於顯存和帶寬,則決定了GPU在運行時的效率。其中顯存決定GPU同時能夠存儲的最大數據,而顯存帶寬,則決定顯存和顯卡之間的數據傳輸速度。

舉一個簡單直白的例子,在一個流水線上,原材料需要從庫房運送到車間進行裝備,然後將成品再運回庫房。顯存決定了庫房能夠放多少原材料,而顯存帶寬,則決定每次從庫房送原材料的速度。如果庫房不夠大,或者材料傳輸速度不夠快,那車間的生產能力再強,也無法生產出成品。所以顯存和帶寬,其實決定芯片能夠參與訓練多大參數規模的大模型,以及訓練大模型的速度。

明白了這些基本概念,我們再用最有代表性的兩家企業,進行對比。

首先是AMD,目前主打的芯片是MI250X,發佈於2021年年底,採用7nm工藝,擁有582億個晶體管,顯存128G,顯存帶寬3.2768 TB/s,FP16峯值性能爲369 TF,只有60個計算單元。

▲圖源:AMD官網,MI250X

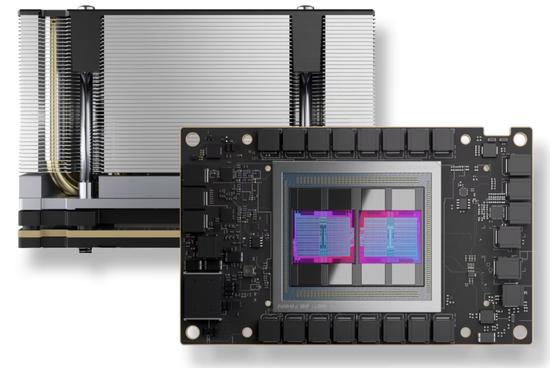

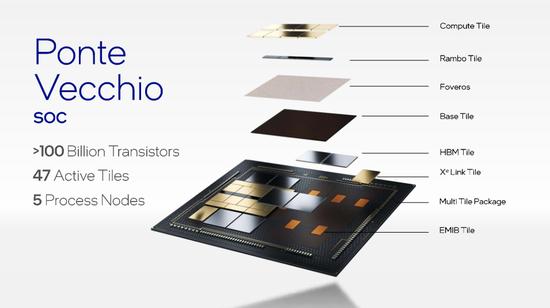

其次是英特爾,目前主打芯片Ponte Vecchio,同樣發佈於2021年,採用7nm工藝,宣稱晶體管數量達到1020億,是全世界晶體管數量最多的芯片。這款芯片顯存128GB,顯存帶寬3.2TB/s,FP16峯值性能184TF,計算單元102個。

▲圖源:英特爾 Hot Chips 演示的幻燈片,展示了 PVC 上的小芯片

我們會發現,即使從單純的數據上看,英特爾和AMD也沒有完全被英偉達甩開,甚至在某些領域,這兩家的芯片還領先英偉達的A100。

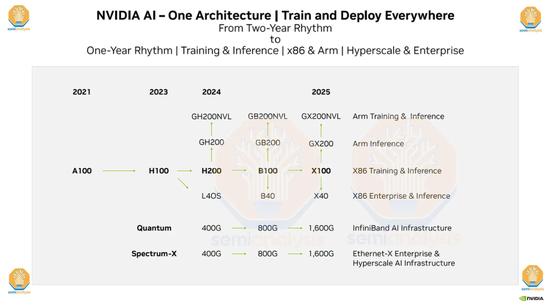

但是這裏有兩個誤區,第一個誤區是,英特爾和AMD這兩款芯片的發佈時間比A100都要晚一年,他們真正對標的對手,其實應該是英偉達在2022年初發布的H100,而現在英偉達的芯片已經更新到H200了。

▲圖源:Semianalysis

第二個誤區在於,硬件指標並不完全等於芯片的整體能力,軟件生態是決定芯片性能和使用的第二個關鍵指標。

這就像手機和操作系統一樣,手機的硬件配置再好,沒有一個好的操作系統,對於消費者來說仍然不是一款好的手機。而這裏需要提到的,就包括英偉達的CUDA平臺、NVLink和Tensor Core等軟件生態。

比如CUDA平臺,我們前面提到的CUDA核心就是這個平臺的產物,它可以提高芯片的並行計算能力;它可以通過編程,提高GPU的能效比,讓同樣的工作耗費更少的能源。

此外,CUDA平臺還支持廣泛的應用程序,包括科學計算、深度學習、機器學習、圖像處理、視頻處理等等,它還允許技術人員通過C++等常用的編程語言來編寫GPU代碼。打一個不恰當的比方,這相當於中國人不用學習英文,直接使用中文指揮外國人做事情,幫助技術人員節省了巨大成本。

但目前市面上大多數程序員已經深度依賴CUDA平臺和開發工具,就像我們使用微信許多年了,你的朋友、聊天記錄、朋友圈都在這個微信上,即使現在出現一個更好用的社交軟件,你也很難遷移。

CUDA帶來的生態壁壘也類似這個道理,其他平臺雖然也有自己的軟件生態,比如AMD有自己的GCN 架構,英特爾有Xe架構,甚至爲開發者提供類似“一鍵換機”遷移功能,但都很難與英偉達競爭。

當然,這裏面也有一些曲線救國的做法,比如以AMD爲首,越來越多的芯片企業採用了“打不過就加入”的策略,選擇將自己的芯片兼容到CUDA平臺,早在2012年的時候,AMD就與Nvidia 達成了一項協議,允許AMD在其GCN架構GPU中使用 CUDA 技術,所以現在我們在AMD的芯片中,也會看到CUDA核心。

當然,對於英偉達來說,CUDA也只是護城河的一部分,其他的技術如NVLink也至關重要。

作爲大模型訓練的GPU,沒有哪家企業會單獨使用一張GPU,每次都會使用至少幾百張卡,甚至上萬張卡一起建立計算集羣。NVLink是一種鏈接技術,可以實現GPU之間的高速、低延遲的互聯。如果沒有這種技術,整個芯片算力的集羣就無法實現1+1>3的效果,而且會增加GPU之間的通信延遲,執行任務的效率會降低,芯片的功耗會增加,最終增加整個系統的運行成本。

大模型訓練實際上是一個非常消耗能源的事情,國盛證券做過一個計算,假設每天約有1300萬獨立訪客使用ChatGPT,那每天的電費就需要5萬美元。而如果沒有NVLink,這筆成本還會指數級上升。

芯片某種程度上就像購車一樣,購車只是第一次成本,之後的油費、保養、保險纔是成本的大頭。所以黃仁勳才說,“AI系統最重要的不是硬件組成的成本,而是訓練和運用AI的費用。”

所以,雖然AMD、英特爾在某些芯片上把價格定得比英偉達更低,但是從長期成本來考慮,具有更優軟件生態和協同、配套工具的英偉達芯片仍然是性價比最高的選擇。

當然,這裏面還要考慮到使用場景的問題。

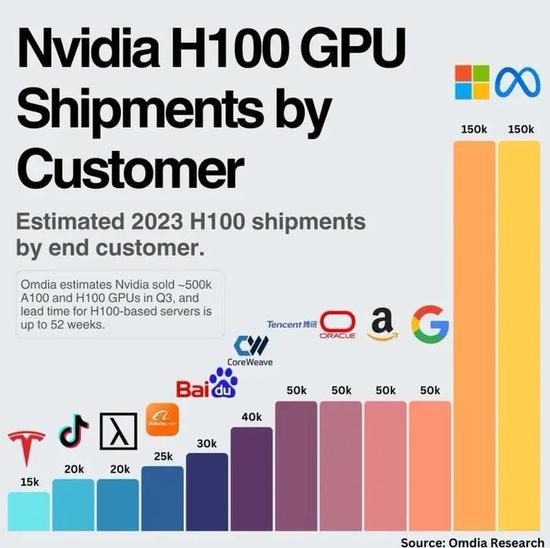

比如英偉達的大客戶,主要是以Meta、微軟、亞馬遜、Google爲代表的雲計算平臺。有媒體報道,頭部雲計算廠商在英偉達H100 GPU整體市場份額中的佔比達到50%。

▲圖源:Omida Research

而云廠商採購芯片的邏輯,主要是構建算力集羣,然後通過雲服務平臺將這些算力再賣出去。但這裏就會存在一個問題,就是雲廠商並不知道客戶會拿這些算力來做些什麼,比如有的企業會用來做機器學習,有企業需要大模型訓練,也有企業需要做大模型推理。

不同的需求,背後對應的算力配置也不盡相同,它需要底層的芯片能夠支持多種編程模型,支持多種數據類型,有較好的可拓展性和良好的性能和功耗等等。而這些,恰恰是英偉達硬件能力加軟件生態帶來的優勢。

綜合來看,無論是從硬件性能,還是軟件生態;無論是從開發工具和部署工具,到長期使用的成本和可開發應用場景。對比同類競爭對手,英偉達都屬於最有性價比,且遙遙領先的存在。

這就是爲什麼明明需要排着長隊、忍受長時間等待,大家卻仍然執着於英偉達芯片的原因。

02

誰想替代英偉達?

難道英偉達真的不能被超越嗎?當然也不是,在巨大的市場利益面前,從傳統半導體巨頭到初創企業,圍剿英偉達的呼聲從來就沒有停止過。

特別是最近幾年,隨着雲計算和雲端AI芯片的火爆,已經有無數的半導體公司說過,自家芯片已經在部分性能上超過了英偉達A100,就像今天也有無數大模型企業會說自己已經在某些方面超過OpenAI GPT-3.5一樣。

在最新披露年報中,英偉達是這樣描述自己的競爭風險的。

公司的競爭來源主要有兩個,一個是 GPU、CPU、DPU、嵌入式SoC和其他加速AI計算處理器產品的公司,比如英特爾、AMD、高通、華爲;另一個是提供基於InfiniBand(無線帶寬技術)、以太網、光纖通道和專有技術的半導體高性能互連產品供應商,比如華爲、思科、惠普這樣的通信公司,以及亞馬遜、微軟、阿里、谷歌、華爲這樣的雲服務公司等等。

特別是第一次被英偉達列爲對手且被反覆提到的華爲。從芯片硬件到軟件,從雲服務到通信解決方案,英偉達幾乎將華爲當做所有領域的競爭對手。

奇怪的是,雖然在2023年8月,科大訊飛創始人劉慶峯就提到華爲的GPU已經可以對標A100了,但其實從客觀的性能、使用成本,軟硬件生態工具,華爲與英偉達之間仍然有着代際的差距。

華爲被如此重視,關鍵在於兩點:

一是市場環境的問題,由於衆所周知的原因,英偉達的高端芯片在國內的銷路並不暢通,在全面國產替代的背景下,其針對中國的特供版芯片在中國的競爭力也在降低。在這樣的背景下,華爲擁有更多的成長空間,不必直接對標英偉達最先進的H200。

另一個關鍵是華爲的生態能力非常齊全,作爲通信起家的企業,華爲不僅擁有自己的芯片,服務器,還擁有自己的雲計算平臺和大模型。基本上,華爲覆蓋了AI這條產業鏈從頭到尾的所有環節,對比英偉達擁有更大的潛力和可能。

如今,華爲的昇騰910B正在瘋狂席捲中國市場,除了科大訊飛之外,國內多地的智算中心也都已經用上了華爲的芯片。《財經》之前報道,華爲昇騰系列產品目前處在供不應求狀態,價格約只有英偉達A100的60%甚至可以更低。

爲了應對國內市場的變化,英偉達也在積極推出新的產品。2月初,有媒體報道,英偉達的新款國內專供芯片H20已經開始在接受經銷商的預定。

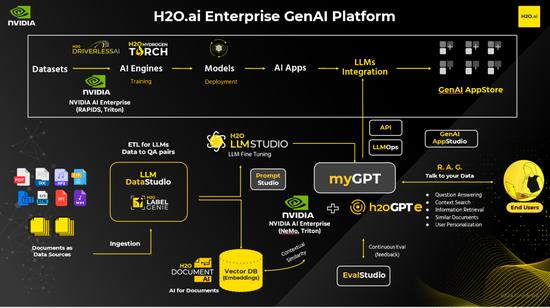

▲圖源:NVIDIA 由H2O.ai和NVIDIA提供支持的融合AI生態系統

而有趣的是,作爲新產品,英偉達H20每張的定價換算成人民幣僅在8.6萬~11萬左右,剛好略低於華爲昇騰910B 12萬元左右的價格。在英偉達承受中國市場壓力的背景下,這被看做是一種防守策略。

除了在國內有被黃仁勳親自認證的競爭對手華爲之外,海外市場英偉達其實也是羣狼環伺。

最虎視眈眈的自然是AMD。

2023年6月,AMD發佈了Instinct MI300,目標是對標英偉達H100,其晶體管數量達到1530億,內存192GB、內存帶寬5.3TB/s,分別是英偉達H100的大約2倍、2.4倍和1.6倍。

軟件上,AMD仍然延續兼容CUDA的策略,一方面通過遷移工具,翻譯CUDA應用的策略吸引英偉達的開發者,另一方面開源自家的ROCm軟件,提高企業和開發者的自主權。

對於芯片算力這麼基礎的部分,沒有企業希望英偉達成爲自己的唯一供應商,所以在MI300推出之後,包括OpenAI、微軟、Meta都紛紛表態將採購MI300。

除了AMD,即使是已經在AI上落後的英特爾,也不甘心錯過這場潑天富貴。

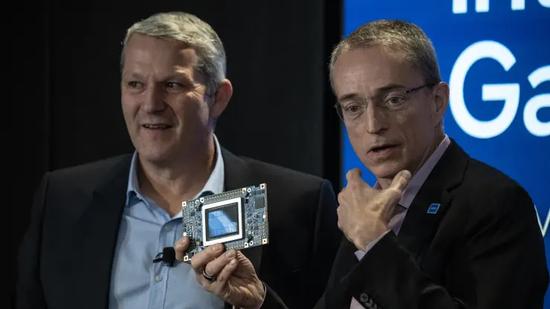

▲圖源:彭博社 英特爾公司首席執行官Patrick Gelsinger於2023年12月14日星期四在美國紐約舉行的英特爾AI Everywhere發佈會上發表講話

英特爾最新的AI芯片Gaudi3將在2024年上市,這款芯片採用5nm工藝,最高配備128GB的內存。按英特爾的宣傳,這款芯片的帶寬是Gaudi 2(7nm工藝)的1.5倍,BF16功率是其4倍,網絡算力是其2倍,並表示Gaudi3的性能將優於英偉達的H100。同時,美國政府也在對英特爾進行扶持,預計將向英特爾提供超過100億美元的補貼。

從戰略上,與英偉達的優勢在雲端不同,英特爾的優勢在與其廣闊個人終端市場。所以英特爾其實將更大的賭注壓在了個人終端的AI化上。英特爾CEO基辛格多次提到,要重構PC體驗,並表達對未來AI PC市場的看好。英特爾希望依靠其CPU在個人PC上的優勢,率先搶佔這一市場,然後再通過消費市場反向促進雲端市場的繁榮,打一波農村包圍城市的戰役。

事實上,芯片的行業特點與軟件、或者互聯網的商業可以通過建立用戶規模,或者生態就建立壁壘實現贏者通喫不同。作爲高度技術密集型產業,芯片技術的代際變化非常大,只要存在技術迭代的機會,後來者就永遠有彎道超車的可能。

芯片不同於軟件,或者互聯網等其他業務模式,建立起一定的用戶規模之後可以一直贏者通喫。只要存在技術迭代的機會,後來者就永遠有彎道超車的可能。

而無論是AMD還是英特爾,亦或者華爲,他們都有深厚的技術研發能力和充裕的資金,這些企業可能會在這個階段暫時落後,但也誰無法篤定,這些企業不會出現一次技術湧現,或者抓住某個技術迭代的關鍵時期後來居上。

從最新財報看,AMD 2023年Q4數據中心的銷售額22.8億美元,同比增長38%,表明市場已經在逐步接納其AI芯片的使用。

而除了AMD和英特爾這樣的老牌玩家之外,這個市場上還有很多創業者在前赴後繼。

最近比較出名的如Groq,其針對大語言模型量身定製的LPU芯片每秒可以生成500個token,遠超英偉達芯片的效率。當然,這個成績仍然是在實驗場景下的結果,最終工程化交付還有很長的距離,且這款芯片也還有許多技術問題有待解決。

但這本質上代表,面對新的場景,如今的芯片的技術仍有創新空間。

所以我們會看到,作爲全球最具代表的AI企業,OpenAI也宣佈了自己的造芯計劃。其創始人CEO Altman前段時間不僅傳出7萬億美元的募資芯片,在這之前更是已經投資了包括Cerebras、Rain Neuromorphics和Atomic Semi在內的至少三家芯片公司。

遠在日本的孫正義,在互聯網時代已經功成名就的他也打算放過這次機會,剛剛從鉅額的投資虧損中解套的他,立馬就提出了募集1000億美元以創立一家人工智能半導體芯片企業的計劃。

有媒體報道,在這次計劃中,軟銀將出資300億美元資金,另有700億美元的資金可能來自中東地區的機構。而在2023年,軟銀集團曾以640億美元的估值收購ARM公司25%股份,這也是孫正義投入芯片的底氣之一。

當然,對於英偉達來說,更大或者更直接的危險還是來自其最大的客戶——雲廠商。

面對巨大的算力需求,國內如百度、華爲、阿里都相繼推出了自己的AI芯片,在國外,包括微軟、亞馬遜、Google也同樣在開發自己芯片。

當然,這些芯片主要針對的是特定場景的計算需求,與英偉達面向通用場景的GPT仍然有不同。但這也代表,雲計算廠商正在逐步減少對英偉達的依賴。而正如前面所提到的,這部分企業纔是真正支撐英偉達業績的主要客戶。

面對這些既定的,或者潛在的市場變化,英偉達自然也沒閒着。據路透社報道,英偉達近期已與微軟等主要雲廠商聯繫,商討爲雲廠商定製AI芯片的問題。

同時,英偉達也在持續推出新的芯片,以期望不斷拉開與後來者的距離。目前,英偉達已經公佈了其下一代AI芯片B100的消息,設計性能要比H100快3倍。

所以,雖然超越英偉達的機會仍然存在,這個世界也從不缺少挑戰“霸權”的勇士,但這個任務顯然還很漫長。