马斯克、奥特曼都发出警告,美国企业家为何如此担忧AI会导致电力短缺?

在“欧洲能源危机”话题退出大众视野后,人工智能(AI)将引起能源短缺的论调又甚嚣尘上。

3月11月,A股新能源板块爆发,光伏和储能板块领涨。这受到了一则行业大咖称“AI的尽头是光伏和储能”的消息驱动。

部分媒体报道称,英伟达创始人兼首席执行官黄仁勋在公开演讲中指出,AI未来发展与光伏和储能紧密相连,需要更全面地考虑能源消耗问题,如果只考虑计算机,需要烧掉14个地球的能源。

但界面新闻并未找到黄仁勋此番言论的公开表述。在今年2月12日于迪拜举行的“世界政府峰会”上,他与阿联酋国务大臣Omar Sultan AlOlama对谈时,明确指出科技进步将控制AI的成本。

- “我们正处于新时代的开端。目前数据中心的安装基数大约有一万亿美元。在接下来的四五年里,我们将拥有价值2万亿美元的数据中心,这些数据中心将为全球的软件提供动力。”

- “你不能只想着要购买更多的计算机,你还必须假设计算机的速度会越来越快,因此所需的总量就不会这么多了。否则,如果假设计算机的速度永远不会变快,你可能会得出一个结论——我们需要14个不同的行星、3个不同星系、4个太阳为这一切提供燃料。”

- “但是很明显的是计算机架构在不断进步。过去的十年中,我们做出的最伟大贡献之一就是将计算和AI提高了一百万倍。因此,无论你认为推动世界的需求是什么,你都必须考虑到,它还将以100万倍的速度变得更大、更快和更高效。”

但类似的表达也并非空穴来风。无论是特斯拉首席执行官埃隆·马斯克,还是OpenAI首席执行官山姆·奥特曼,都在近期提及AI迅速发展背后的能源隐忧。

2024年2月29日,马斯克在博世集团举办的BCW(Bosch Connected World)的视频采访环节上表示:

- “AI算力的限制是可预见的,我在一年前就预测到了芯片短缺,神经网络芯片。很容易预测,下一个短缺将是降压变压器(voltage stepdown transformers)。如果从电力公司获得100-300千伏的电力,那么降压到6伏会是一个很大的降压过程。我不那么好笑的笑话是‘你需要用变压器来运行(AI)Transformer模型’(you need transformers to run transformers)。”

- “那么,下一个短缺将是电力,我认为到明年,将没有足够的电力来运行所有的芯片。”

- “事实上,电动汽车和AI并行发展,两者都需要电力和变压器,我认为这正在创造对电力设备和发电的巨大需求。”

2024年1月16日,在达沃斯世界经济论坛年会期间举办的的彭博社活动上,奥特曼表示:

- “我们需要比之前认为的多得多的能源。我对世界的理解是,未来的两种重要货币是智能计算和能源。无论是我们的想象力,还是让想法变为现实的能力,以及运行计算的能力,都离不开这两者。我认为我们仍没有充分意识到这项技术对能源的需求。”

- “如果没有重大突破,我们就无法实现这一目标。我们需要核聚变,或者极度更便宜的光伏加上储能,或是从没有人真正规划过的规模水平的技术。”

- “公平地来说,AI的发展将需要大量能源,但我坚信这会迫使我们更多地投资于能够提供这种能源的技术。”

AI会导致能源短缺吗?

目前,AI在全球用电量的占比并不大,至少暂时不足以引发规模能源危机。

据国际能源署(IEA)统计,2022年,全球不包括加密货币挖矿在内的数据中心消耗了大约460太瓦时(TWh)的电力,占全球总需求的1-1.3%。

宾夕法尼亚大学电子工程和计算机科学教授本杰明·李和哈佛大学教授大卫·布鲁克斯的研究表明,2015-2021年间,数据中心的能源使用量平均每年增长25%。

随着生成式人工智能引爆全球,大模型公司百花齐放加上ChatGPT使用率飙升,导致AI电力消耗大幅增加,也推动数据中心耗电量快速抬升。

据《纽约时报》援引全球数据中心标准组织之一“国际正常运行时间协会”的预测,到2025年,AI业务在全球数据中心用电量中的占比,将从2%猛增到10%。一项研究预测,到2027年,AI服务器每年的用电量将在85-134太瓦时之间。这相当于阿根廷、荷兰和瑞典一年的用电量,约占目前全球用电量的0.5%。

IEA还指出,到2026年,全球总体电力需求预计将增长3.4%。同时,可再生能源如风能、太阳能和水力发电,以及空前高水平的核能新增装机,将满足新增的电力需求。

尽管AI用电量占比暂时不会在全球层面爆发式增长,但训练和使用AI确实耗电、耗水,过程中还有大量碳排放。

据《细胞》期刊发布的一篇题为《人工智能不断增长的能源足迹》的论文估计,一个标准的谷歌搜索消耗0.3 Wh的电力,而人工智能驱动的谷歌搜索消耗3.0 Wh的电力,拥有十倍的差距。

据《纽约客》杂志报道,据国外研究机构的报告,ChatGPT每天要响应大约2亿个请求,在此过程中消耗超过50万度电力,而每一个美国家庭的平均用电量只有29度。这意味着,ChatGPT每天用电量相当于1.7万个美国家庭的用电量。

为何美国企业家会担忧?

AI产业呈现区域集聚性发展的特点。密集的数据中心和脆弱的电网,是美国企业家产生危机感的重要原因。

IEA数据显示,全球8000个数据中心中有33%位于美国,16%在欧洲,近10%在中国。美国的数据中心在2022年消耗了200太瓦时的电力,相当于美国电力需求的4%。

该机构预计,未来几年美国数据中心用电量将快速增长,从2022年的200太瓦时增加到2026年的近260太瓦时,占总电力需求的6%。

此外,在《通货膨胀削减法案》等政策引导下,大量清洁技术工厂也在美国各地激增,成为新的用能大户。

3月7日,《华盛顿邮报》发布报道指出,AI和清洁技术制造业的繁荣正把美国的电网推向崩溃的边缘。如佐治亚州对工业电力的需求飙升至创纪录的高点,预计未来十年的新用电量是最近的17倍;北弗吉尼亚需要相当于几座大型核电站的电力,来为所有规划和在建的新数据中心提供服务。

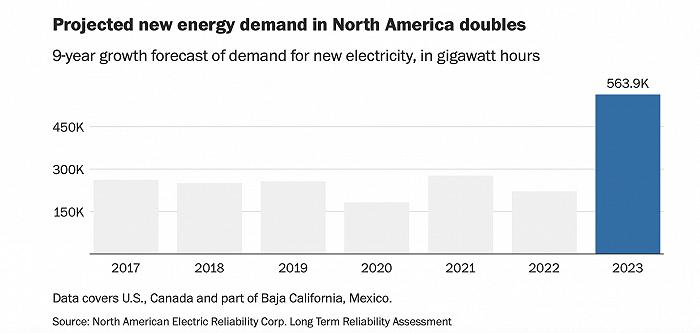

预计北美新能源需求将翻倍,图片来源:《华盛顿邮报》

由于审批程序复杂,缺乏投资吸引力等原因,美国输变电主网一度处于停滞状态。美国能源部数据显示,美国电网投资在1975-1999年逐年下降,平均每年下降8600万美元,直到2005年才恢复到1975年的投资水平。

这导致了美国老化严重的电网,使许多地区面临电力短缺的风险。

美国能源部在2015年的电网基础设施审查中发现,美国70%的输电线路已经使用了25年以上,而线路的使用寿命通常为50年。该部门2014年的报告表示,美国变压器的平均使用年限达到38年,其中70%的变压器使用年限超过25年。

根据路透社2022年的研究,美国过去六年的停电次数比前六年增加了一倍多。2020-2022年期间,电力系统在墨西哥湾沿岸的飓风、西海岸的野火、中西部的热浪和德克萨斯州的严寒中崩溃,造成了长时间的、有时甚至是致命的停电。

大型数据中心的用电故障,将给业主和客户带来巨大的损失,因此其往往需要可靠、不间断的电力,甚至配备额外的供电设备应对停电。

《华盛顿邮报》表示,随着越来越多的公司对美国电网的堵塞感到沮丧,他们已更多地转向离网的分布式能源。微软和谷歌等公司希望,能源密集型工业运营最终可以由现场的小型核电站提供动力。

奥特曼则已投资了两家核能相关的初创公司,分别为聚变公司Helion Energy和聚焦下一代快堆技术的Oklo。