銀行人臉識別系統被攻破,漏洞可能出在哪兒?

“銀行人臉識別系統被攻破”的新聞引發公衆對於其安全性的擔憂。該如何應對技術的漏洞和挑戰?我們採訪了相關專家。

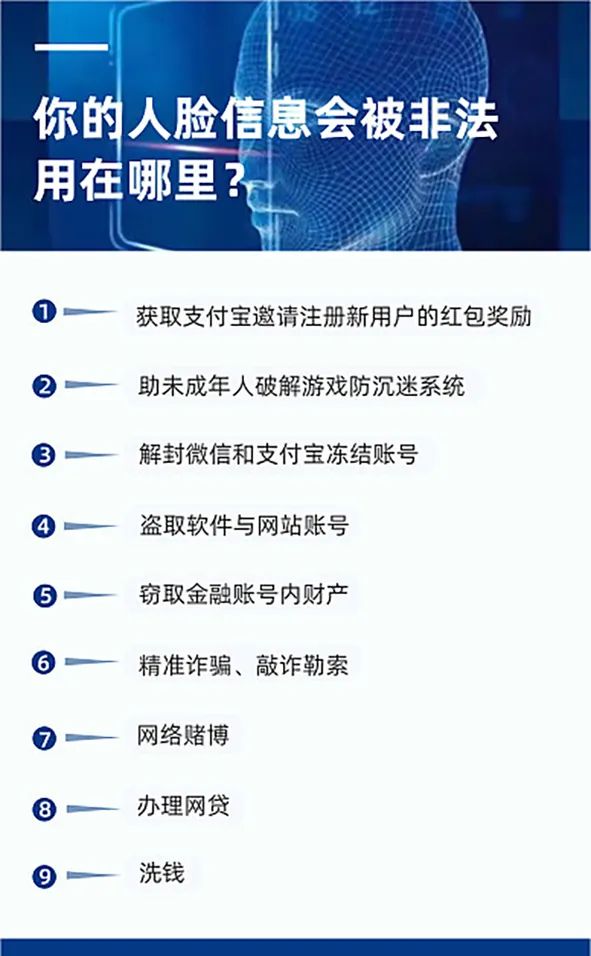

“騙子用‘假人臉’盜刷女子數十萬”“滴滴違法收集用戶個人信息(包括人臉識別信息1.07億條)被罰款80.26億元”……最近,與人臉識別有關的話題頻頻成爲熱點。在“刷臉”越來越普及的今天,這些案例不禁令人深思:我們進行人臉識別到底是增加了額外的保障,還是不必要的安全隱患?

針對這個問題,北京科技報對重慶郵電大學高新波教授進行了專訪。作爲相關領域內的專業學者,高新波對人臉識別技術過去的發展歷程、當下如何應對破解和挑戰、未來將如何發展等作了詳細介紹。

- 人臉識別系統有漏洞

北京科技報:近日“假臉刷銀行卡”新聞引起了大家對人臉識別系統漏洞的關注,您覺得這件事從技術上如何解讀?

高新波:目前投入應用的人臉識別系統的圖像採集方式有兩種,其中一種是上傳二維圖像到系統,系統在特徵空間裏通過比對該圖像和系統中註冊的人臉圖像以作識別。這種方案較爲簡便,但它的漏洞在於:任何人使用符合條件的二維人臉圖像都可以被認證成功。例如,2019年就有幾位小學生用打印的照片,“破解”了豐巢快遞櫃的刷臉取件功能。

所以,像銀行這樣的金融單位就會使用第二種人臉採集方案,即採集人臉圖像的同時進行活體驗證,以確保驗證者爲真人,防止他人惡意盜用照片。具體來說,就是要求採集人臉信息期間,用戶按指令做眨眼、張嘴、等動作。

但活體檢驗的一大漏洞就在於:系統假設這張臉和活體屬於同一個人。如果李四帶上了張三的面具,人臉識別系統檢測到了張三的臉,同時李四完成了活體檢測所需的動作,這種情況下系統就無法識別這個“本我”其實是李四而不是張三。此前還有新聞報道,斯坦福大學的研究者發明了通過軟件進行表情移植的“換臉”技術。最近的新聞中,不法分子就是利用類似的“高科技”來攻擊人臉識別系統,盜刷銀行卡的。

北京科技報:出現這樣的漏洞,我們應該如何應對?

高新波:我們可以採用“可見光+紅外”雙模攝像頭的識別方式,即以可見光檢測到人的表觀,以熱紅外探測人臉的熱量分佈。只有光學人像和熱紅外溫度分佈圖皆與個人保持一致,才能通過身份的辨識。這麼一來,即使有人使用軟件換臉、戴面具或長得相像也無法冒名頂替了。

再者,我們也可以採用雙模或者多模的驗證方式,在人臉識別之外,加上虹膜、指紋、指靜脈、掌紋、聲紋等不同角度的驗證方式,這樣至少能夠彌補下單一識別技術的漏洞。

(圖片來源:視覺中國)

- 人臉識別“發展中的痛”

北京科技報:人臉識別技術在發展過程中還遇上過哪些挑戰?如今,相關技術發展到了哪一階段?

高新波:人臉識別這幾年發展得還是比較快的。最早取得成功的人臉識別案例(基於圖像識別技術)來自美國麻省理工學院的媒體實驗室,一位名叫彭特蘭(AlexPentland)的學者提出了“特徵臉”(Eigenface)方法。簡單來說,就是以分解圖像中的特徵值來進行人臉識別,但是該技術對光照的干擾比較敏感,所以當時就沒有投入應用。

後來,學術界又不斷提出新的方法,但基本的思路都是通過圖片特徵提取,然後再設計一個分類器進行識別。研究特徵提取方式的領域,這些年來進展很快。近年來,人們主要採用深度學習來做人臉識別,將特徵提取到分類器設計等都合爲一體,即“端對端”的識別方法。

如今,在大數據和深度學習這兩個技術的加持下,人臉識別的精度高、魯棒性(Robustness,即抵抗變數的性能)也較好。所以,人臉識別目前已經走上了實用化的道路。

早期研究人臉識別,準確率但凡比別人的方法高1%,就能發表一篇論文;現在已經不可能達到1%了——因爲已經達到99%以上了。我們國家人工智能的發展中,一個最重要的、落地比較成功的領域就是模式識別,可以說在圖像識別方面,我國人臉識別技術在國際上處於領先地位。

北京科技報:我們聽說有些面貌相似的人(如雙胞胎)可以互相進行人臉認證。對於如今的人臉識別系統,這個問題是否無解?

高新波:理論上,識別面貌相似的人會增加識別難度,降低準確率,但並非無法做到。現實中那些長得十分相像的人,他們的父母或者熟悉的人仍然能分辨出來,說明這些面孔還是有區別的,人工智能肯定也可以識別出來。我們需要做的是加強對系統的訓練,如採集大量的雙胞胎人臉數據作爲訓練樣本,讓神經網絡訓練時專門把他們區分開,加大識別力度。

不過,很多單位認爲沒必要爲了個別的人進行技術投資。AI的深度學習訓練比較耗費能源,大模型的神經網絡層數和節點都非常多,每一次訓練都會花費大量的電費。所以,識別面貌相似者並不是技術上做不到,只是基於降低成本等因素綜合考慮,我們不如採用多重驗證來解決這個問題。

- 人臉識別與隱私保護如何兼顧?

北京科技報:有關人臉信息被泄露的新聞,引起了大衆對個人隱私安全的擔憂。我們要如何更好地保護相關隱私呢?

高新波:這是個很關鍵的話題,大數據隱私保護是我們始終在思考的研究方向。

我們最近在做一個保護個人隱私的視頻監控系統,即在視頻監控裏實現“匿名化”。匿名化的方案有兩種,一種是系統對人臉做變形處理,處理後的面孔人類無法辨認,只有機器仍可識別(A站在鏡頭前,電腦記錄下來的卻是不存在的Z)。通過如此“捏造”匿名人臉,可以保護隱私。

另一種是“換臉”,即在數據庫內造出一個和現有人臉都有差距的面孔替換某個人,然後把原有的人臉用水印等方式嵌入其中。當需要追溯某個人的時候,通過技術就可知道這個人是誰;一般的系統沒有這個技術,他們所能看到的就不是本人了。

我們的想法,是在監控相機里加一塊芯片、一個模塊進行匿名化處理,讓鏡頭傳出來的照片和視頻不是‘本我’;同時,只授權公權力部門(如警方)掌握追溯信息的能力,通過這樣的方式來保護我們的隱私。

(圖片來源:視覺中國)

北京科技報:您剛纔說的“匿名化”會使人類無法辨別,但機器仍可識別;那麼有方法可以讓人能識別而機器不能識別嗎?

高新波:可以。現在有一類新的技術叫做“對抗學習”,即在臉上貼特殊的貼片,干擾機器識別,這些貼片被稱爲對抗樣本。如果將來要保護個人隱私不被過度採集的話,可能會應用貼片一類的東西,一旦我們貼在臉上,電腦、監控等就不能識別了,這個技術現在也有人在做。而且,這些貼片可以設計得比較小,方便現實生活裏其他人辨認,只有電腦無法辨認。

爲什麼貼個東西電腦就無法辨認?因爲人工智能的“可解釋性”很差。換句話說,我們只知道它們能識別,但它們到底怎麼識別卻難以言說,因爲它們所“深度學習”的,是神經網絡設計出來的“特徵”,人類根本無法理解這些特徵。所以,科學家發現,有時在一幅圖上添一點東西,電腦便難以識別,所以我們可以利用這個特點來拓展對抗樣本的用途。

其實,人臉識別領域中,值得研究的地方還有很多。但保護隱私是目前最關鍵的問題。歸根到底,我們還是希望科學技術被用於造福人類,而不是用來製造麻煩。

(圖片來源:視覺中國)

北京科技報:誠如您所說,人臉識別技術已經達到了一定的高度。但不法分子的“破解”花招也層出不窮,人臉識別似乎成爲了潛在的安全漏洞和隱患。請問您如何看待這點?

高新波:這也是一個很重要的問題。科學技術像是一把雙刃劍,一方面給大家帶來了便利,另一方面又產生了隱患。

科學技術本身是沒有價值觀的。可是我們人類有價值觀,知道是非、黑白,所以科技的價值觀取決於使用者。如果使用者擁有正確的價值觀,那麼科技帶來的就是正面作用,反之則帶來負面影響。不過,二者的博弈也會促使科學技術進步,在不斷解決問題的過程中向前發展。

由於技術的發展總是滯後於問題,我們現階段必須儘可能地防止問題發生。這就引申出兩條路線,其一是社會的教化,我們需要給用戶正確的價值導向、價值引領;二是制度法規的約束力量,法律除了訂立規章制度、約束以及嚴懲不法分子之外,亦應賦予相關主體很強的法律義務,敦促他們保護人們的生物信息。總之,我們既得“以德服人”,又得“依法治國”。

撰文/王慧深(實習) 編輯/丁林

來源:北京科技報

責任編輯:朱學森 SN240