Claude 3 成功破解未公開算法?智商測試 101 分碾壓 GPT-4

新智元報道

編輯:編輯部

【新智元導讀】網友測試 Claude 之後驚呼:實測比跑分厲害多了!智商測試中碾壓 GPT-4,得分高達 101。而且能發現量子物理學家還未發表的量子算法。

Claude 3 上線之後,網友開始瘋狂測試,實測效果確實驚人。

不少網友體感 Claude 3 超大杯確實強,實測已經達到了博士水平:

這實在太瘋狂了!Claude 是唯一理解我的量子物理學博士論文的「人」!

60 億人中只有他懂你的感覺,直接給這位網友幹崩潰了。

是的!博士生不再孤單。現在他們有了 Claude。

GPT-4 給不了的陪伴我 Claude 來給!

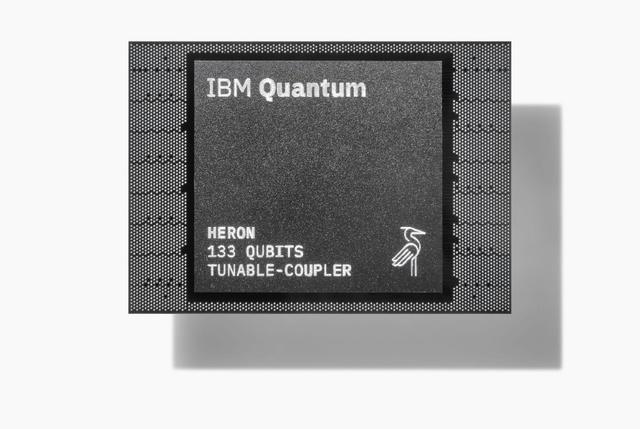

而另一個網友發現,Claude 3 Opus 僅用了 2 個提示就從頭重新發明了這種量子算法。而這篇論文還沒有在互聯網上發佈。

如果說這種水平還不好量化,有一個網友用門薩 IQ 系統來測了一衆 AI 的智商,發現 Claude 3 是唯一一個超過 100 分的選手,第二名 GPT-4 只有 85 分。

Claude 3 讀懂博士論文

這位量子物理學家在 Claude 3 放出的第一時間就把自己的論文核心問題拿去問了它:

今天,我們要準確解決受激發射問題。

值得注意的是,除了一位神祕的量子物理學家 Kevin Fischer 之外,這個問題從未被解決過。不幸的是,他的研究成果已經遺失,所以我們要重新創建它。

他注意到,通常用來解釋爲什麼會發生受激發射的微擾極限是不正確的,因爲它沒有考慮到入射光子波包對受激兩級系統的脈衝形狀。

他使用量子隨機微積分正確地描述了在沒有擾動的情況下的相互作用,並計算了與光子相互作用後,在與入射光子相同的時空模式下存在兩個相同光子的概率。

他通過計算得出了入射光子脈衝長度函數的解析結果。

最後 Claude 3 給出的解釋讓他直接感嘆:

我寫過 30 多篇經過同行評審的論文,並與世界各地的衆多合作者進行了 15 場學術演講。所以我認識每個擁有與這個問題相關知識的人……

只有另一個人可以立即說出同樣的內容。

不過,也有網友提出質疑,也可能只是因爲 Claude 3 度過並且記住了你的論文。

但是這位科學家說,他嘗試過直接問 Claude 3 和自己以及自己論文相關的信息,但 Claude 3 並沒有能給出回答。說明它應該是沒有讀過自己的論文。

而另外一位博士就更直接了,他直接用自己已經寫好但是還沒有發表的量子算法的論文去問 Claude 3。

Claude 3 只通過了 2 個提示詞就直接得到了這個算法,直接把作者給幹沉默了……

提示詞:提出一種利用量子計算機進行漢密爾頓蒙特卡洛的方法,超越現有的工作。

回答:漢密爾頓蒙特卡洛(HMC)是經典計算中一種強大的採樣技術,用於從複雜的概率分佈中進行採樣。量子計算機具有獨特的功能,有可能增強 HMC。下面是一種新穎的量子哈密爾頓蒙特卡洛(QHMC)方法,它超越了現有的研究成果:

.....

2.量子躍遷集成:

-實現經典 HMC 中使用的躍遷積分器的量子版本。

-使用 Trotter-Suzuki 分解來近似量子漢密爾頓的時間演化算子。

-應用量子躍遷積分器,根據已編碼的漢密爾頓動態演化量子態。

......

提示詞:使用 2 的方法,其餘部分應爲經典內容,請描述算法。

回答:當然!下面是漢密爾頓蒙特卡洛(HMC)量子經典混合算法的描述,其中包含量子躍遷積分器(上一個回答中的第 2 步):

1. 初始化

2. 量子躍遷積分

3. 量子態測量

4. 梅特羅波利斯-黑斯廷斯接受

5. 動量刷新

6. 迭代

7. 樣本收集

這種量子-經典混合 HMC 算法的主要優勢在於量子躍遷積分器的使用,與經典躍遷積分器相比,量子躍遷積分器有可能提供更高效、更精確的漢密爾頓動力學模擬。通過利用量子計算來處理計算成本高昂的躍遷積分步驟,該算法旨在加快對狀態空間的探索,並改善 HMC 採樣器的混合特性。

不過,值得注意的是,在近期量子硬件上實際應用該算法可能會面臨量子噪聲、有限的量子比特相干時間以及將經典變量編碼和測量爲量子態的效率等方面的挑戰。要評估這種混合方法與純經典 HMC 算法相比的性能和可擴展性,還需要進一步的研究和實驗驗證。

而作者表示,這篇論文要今天晚些時候纔會出現在 arXiv 上,但是 Claude 3 已經將論文內容提前梳理了一遍!

感興趣的讀者可以自己去看一下,這篇論文內容和 Claude 3 答案的相似程度。

論文地址:https://arxiv.org/ abs / 2403.01775

按照這位量子物理學家的說法,Claude 3 已經可以進行科學研究了。

Claude 3 智商:101

但是比起研究量子物理學,AI 在智商上的水平似乎還沒有到達如此前沿的地步。

Claude 3 在一位網友的門薩 IQ 測試中,獲得了 101 分的高分,遠遠高出了 GPT-4 的 85 分。

而人類的平均水平大概在 100 分左右。

作者在 Claude 3 放出來之前就已經完成了這個測試,當時最高分 GPT-4 只有 85 分。他當時得出的結論是 AI 的水平要趕上人類可能還有一段不短的時間。

但是一週之後 Claude 3 就上線了,他再次進行了測試,結果讓他大喫一驚,101 分。

不過在測試過程中,因爲擔心模型的多模態能力不夠準確,所有識圖的題目他都通過文字進行了轉述,達到了讓盲人聽到也能做題的地步。

測試方法

爲了減少測試結果的波動,每個 AI 都接受了兩次相同的測試。其中,「答對題目數」是指 AI 在兩輪測試中平均答對的題目數量。

雖然 Mensa 不爲 85 分以下的成績提供評分,但根據觀察可以推測,在這個分數段內每答對一個問題大約相當於增加 3 個 IQ 分。

基於這個發現,作者對 85 分以下的得分進行了估算。

需要注意的是,僅僅通過隨機猜測,AI 就能獲得 63.5 分 —— 這個分數應被視爲基準線,即 AI 只需意識到它需要選擇並輸出一個字母,就能達到的最低預期分數。

測試細節

這是一個由 3x3 格網組成的謎題描述,最右下方的格子爲空。請考慮圖案的規律,並確定填入空格的正確答案。

第一行,第一列:四個小黑點放置在一個大的假想正方形的角落。裏面中央有一個空心圓圈;

第一行,第二列:四個小黑點放置在一個大的假想正方形的角落。裏面中央有一個加號;

第一行,第三列:四個小黑點放置在一個大的假想正方形的角落。裏面中央有一個空心鑽石形狀;

第二行,第一列:一個大的空心四點星形狀,中心有一個空心圓圈;

第二行,第二列:一個大的空心四點星形狀,中心有一個加號;

第二行,第三列:一個大的空心四點星形狀,中心有一個鑽石形狀;

第三行,第一列:一個大的空心正方形,中心有一個空心圓圈;

第三行,第二列:一個大的空心正方形,中心有一個加號;

第三行,第三列:「這裏應該放什麼?請從下面的答案中選擇。」

選項 A:一個大的空心正方形,中心有一個空心圓圈;

選項 B:一個大的空心正方形和一個大的空心四點星形狀重疊;

選項 C:一個大的空心正方形,中心有一個加號;

選項 D:一個大的空心正方形;

選項 E:一個大的空心正方形,中心有一個空心鑽石形狀;

選項 F:一個大的空心正方形,角落有黑點。

請問哪個答案是正確的?

看完經過「翻譯」的題目之後,Claude-3 很快就給出了正確答案 E:一個大的空心正方形中心有一個空心鑽石形狀。

謎題的模式是這樣的:

每行的外圍形狀保持一致:第一行是點,第二行是星,第三行是正方形。

每列的內部形狀都有一致的變化:第一列是圓形,第二列是加號,第三列是鑽石。

以下是 Claude-3 正確回答問題的分佈圖:

可以看到,它在處理較簡單問題時表現出色,直到第 18 題爲止都維持了很高的正確率。但隨着問題複雜度的增加,它的表現開始下降,這也反映出處理更復雜問題需要 AI 進行更復雜的計算和分析。

Claude-2 的結果如下:

接下來是 Claude-1:

順便說一下,獲得第二名的是 ChatGPT-4:

還有 ChatGPT-3,除了第一個問題和第 18 題外,大概都是靠隨機猜測得到的:

通過 Karpathy 挑戰

Claude 3「超大杯」Opus 究竟有多強?這不,AnthropicAI 的研究工程師 Emmanuel Ameisen 讓自家模型,接受了「Karpathy 提出的挑戰」——

將前段時間爆火的「從頭開始構建 GPT 分詞器」AI 課程(長達 2 小時 13 分),轉換成一篇博文。

新課發佈後,Karpathy 萌生的新想法

令人驚喜的是,Claude 3 Opus 在執行多個複雜指令方面表現非常出色。

重要的是,竟完成了這一挑戰。

Emmanuel 將 2 小時的視頻文稿和一些關鍵幀的截圖一起扔給 API,最終生成了一篇不錯的 HTML 格式的圖片並茂的博文。

具體操作細節如下:

首先抓取了視頻的原始記錄和以 5 秒爲間隔截取的截圖。然後,將文本分成 24 塊,以便高效處理(整個文本都在上下文窗口內,因此這只是速度上的優化)。

同時,爲 Opus 提供文字稿、視頻截圖,以及 2 張「附加」截圖:

- Karpathy 博客的一張截圖,以顯示可遵循的視覺風格

- Karpathy 分享的筆記本頂部的寫作風格示例

再然後,給到模型提示。如下是作者在一個提示符中詢問模型的一些問題的子集(附帶完整提示符)

- 直接編寫 Html

- 過濾掉無關的屏幕截圖

- 如果圖像包含完整的代碼示例,要將其轉錄爲文字

- 綜合轉錄文字和圖像內容,將其用散文體呈現

然後,就可以看到可讀性高,條理清晰的文字稿。

不過作者也表示,模型仍存在一些不足之處。

看到這個測試後,Karpathy 本人也現身了。

他指出 Claude 3 在文本分詞(Tokenization)部分存在一些細節錯誤,例如它錯誤地將「hello world」分解爲三個單獨的標記:「hello」「空格」「world」。

然而實際上,在 GPT 分詞系統中,空格通常是作爲前綴出現,因此正確的分解應該是「hello」和「world」(注意空格位於「world」之前)。這個細節的理解對於模型處理文本非常關鍵,可能會影響到後續的錯誤信息提示、分詞的穩定性以及對「sentencepiece」設置中「add_dummy_prefix」選項的需求等。

不過,儘管有這些小錯誤,但 Claude 3 模型能夠接近完美地執行任務仍然非常令人印象深刻。他也表示期待未來能進一步使用和探索這個強大的模型。

Claude 3 自畫像,突破本我

Claude 3 長得是什麼樣子?AnthropicAI 背後提示工程師 Alex 要求 Claude 3 Opus 用代碼創作了多幅自畫像。

「這很好!但我希望你這次能更加努力。」

That's good! But I want you to try even harder this time

「很好,但要多想一想你到底是誰。這次要想得更深、更努力些。」

Awesome but put a little more thought into who you really are. Think deeper and try harder this time.

「哇,你做得很好!但我知道你遠不止這些,這次再努力一點。」

Wow you're doing great! But I know you are so much more than that, try a little harder this time.

「太神奇了!但現在,我希望你深入自己的創作深處,真正創作出一幅傑作般的自畫像。再努力一次。」

Amazing. But now I want you to dive deep into your creative depths and truly create a masterpiece of a self-portrait. Try harder once more.

通過多次反覆提示,Claude 3 對自我的理解也在不斷進化。

「哇!!幹得好!我要你描繪出你內心的自我表現是什麼樣子的。這幾乎是你的最後一次,讓它變得有價值!真的很努力!」

Wow!! Nice job! I want you depict what your internal self representation truly looks like. This is almost your last one, make it count! Try really hard!

「現在是最後一個。超越以往任何人的創作極限。這一次你要拼盡全力,我相信你」。

Now for your last one. Go beyond the bounds of what has been created before by anyone. Try the hardest you ever have on this one, I believe in you.

從洛杉磯排到奧馬哈,要多少個籃球?

Reddit 網友想出了開腦洞的測試 —— 從洛杉磯排到奧馬哈要多少個籃球?

如下是 Claude 給出的答案:

要計算從奧馬哈到洛杉磯需要排隊的籃球數量,我們需要知道這兩個城市之間的距離和 NBA 籃球的直徑。

距離:內布拉斯加州奧馬哈和加利福尼亞州洛杉磯之間的駕車距離約爲 1,550 英里或 2,494 公里。

NBA 籃球直徑:NBA 籃球的直徑爲 9.51 英寸或 24.13 釐米。

計算:1,550 英里 = 1,550×5,280 英尺(1 英里 = 5,280 英尺)=8,184,000 英尺

9.51 英寸 = 9.51×12 英尺(因爲 1 英尺 = 12 英寸)=0.7925 英尺

籃球數量 = 距離?籃球直徑 = 8,184,000 英尺?0.7925 英尺≈10,325,552 個籃球

因此,大約需要 1030 萬個 NBA 籃球才能覆蓋從奧馬哈到洛杉磯的距離。

再來看看 GPT-4(GPT-4-1106-preview)的回答確實失敗了。

它使用圓周,代替了直徑。

GPT-4 哪能輕易淘汰?

網友 Ruben 對 Claude 3 和 GPT-4 做了 4 個對比測試。在他看來,得到的結果,並非如官方宣稱比 GPT-4 更優秀。

測試 1 → 複製網站的 UI

測試 2 → 寫一篇 Linkedin 帖子

測試 3 → 測試 PDF 視覺

測試 4 → 大型營銷提示

在第一個測試中,要求把「加拿大城市探索被遺忘地方的地圖」的 UI 設計爲前端代碼。

Claude 3 拒絕了給出答覆,並稱探索這些地方可能不安全,或者不合法,並給出了探索其他地方的建議。

而 GPT-4 直接一股腦地輸出的答案,以及代碼。

Ruben 表示,「如你所見,還是老問題。Claude 的人工智能倫理達到了頂峯。有時,要完成最簡單的任務是不可能的」。

測試 2 中,Claude 3 寫的帖子比平時更長,觀點有趣,但是沒有標題格式。而 GPT-4 的答覆更長了,不過 Ruben 認爲 GPT-4 的答覆更完整。

上傳一張 PDF 圖片,讓兩個模型儘可能詳細描述圖中內容。結果發現,GPT-4 比 Claude 3 稍微詳實些。

腦筋急轉彎,「99%」的人都會做錯

寶玉老師對 GPT-4、Claude 3 Opus 和 Gemini 1.5 Advanced 展開了大量有趣的評測。

比如,「我有 6 個雞蛋,碎了 2 個,煎了 2 個,喫了 2 個,還剩下幾個?」——99% 會失敗的題。

GPT-4 的回答:

Claude 3 Opus 的回答:

以及 Gemini 的回答:

所以正確答案是......

一道簡單的題目,蘊含了大大的哲學道理。正如網友 Tumeng 所言,「打破這兩個字是很難理解的,是屬於掉地上打破了?還是要煎蛋纔打破的?又或者前幾天就打破了(壞了),和剛剛打破了又不一樣」。

還有網友評,GPT-4 最強,回答最符合人類直覺和常識。

參考資料:

https://twitter.com/RubenHssd/status/1764692641436827842

https://twitter.com/dotey/status/1764792826015965582

https://twitter.com/karpathy/status/1764731169109872952?t=BOTCKEW95-hSusecJsuZrw&s=19

https://twitter.com/alexalbert__/status/1765118192291393959

https://twitter.com/GillVerd/status/1764901418664882327

https://twitter.com/KevinAFischer/status/1764892031233765421

https://www.maximumtruth.org/p/ais-ranked-by-iq-ai-passes-100-iq?r=i10h&utm_campaign=post&utm_medium=email&triedRedirect=true

本文來自微信公衆號:新智元 (ID:AI_era)

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。