蘋果推出300億參數MM1多模態大模型,可識別圖像推理自然語言

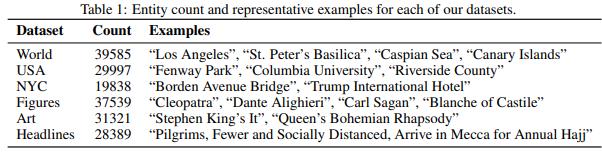

據IT之家,近日,在一篇由多位作者署名的論文《MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training》中,蘋果正式公佈自家的多模態大模型研究成果 —— 這是一個具有高達300億(其他爲30億、70億)的多模態模型系列, 它由密集模型和混合專家(MoE)變體組成,不僅在預訓練指標中實現SOTA,在一系列已有多模態基準上監督微調後也能保持有競爭力的性能。MM1多模態大模型擁有圖像識別和自然語言推理能力。