AI迎來全球管控時代 學者呼籲建立國際監管機構

全球在人工智能風險監管方面的步伐在加快。

當地時間11月1日,英國人工智能安全峯會(Artificial Intelligence Safety Summit, AISS)首日,英國政府在位於英格蘭南部的布萊切利莊園宣佈,多個在人工智能領域領先的國家和地區,包括美國、歐盟和中國,就人工智能帶來的機遇和風險,以及各國政府攜手應對挑戰的必要性達成了共識,並簽署了相關協議。英國政府隨後發佈了這份名爲《布萊切利宣言》(下稱《宣言》)的協議。

根據科技部官網消息,科技部副部長吳朝暉出席人工智能安全峯會,並於1日舉行的開幕式全體會議上發言。與會期間,代表團參與人工智能安全等問題討論,積極宣介中方提出的《全球人工智能治理倡議》,並將與相關國家開展雙邊會談。

中方指出,此次峯會爲各國提供了人工智能安全與國際治理議題的重要對話平臺與交流合作機會。人工智能治理攸關全人類命運,是世界各國面臨的共同課題。發展人工智能,應當積極倡導以人爲本,智能向善,加強技術風險管控,並在相互尊重、平等互利的原則基礎上,鼓勵各方協同共治,增強發展中國家在人工智能全球治理中的代表性和發言權,不斷彌合智能鴻溝和治理能力差距。

必要性和迫切性

在日內一場公開講話中,英國科學、創新和技術大臣米歇爾·唐蘭(Michelle Donelan)稱,《宣言》“是一項具有里程碑意義的成就”,它爲圍繞人工智能相關風險的全球討論奠定了基礎,也讓國際社會意識到,必須加深對人工智能相關風險的理解並採取應對舉措,因爲“這是安全地利用人工智能帶來的機遇的唯一途徑”。

也有觀點認爲,從某種意義上講,這份宣言可以視作國際社會首次就監管人工智能的必要性和迫切性做出正式聲明,但就監管力度等問題仍存分歧。

總體來看,《宣言》最重要的內容包括兩點:一是人工智能風險監管的必要性和迫切性,二是人類應對人工智能風險必須通過國際合作。

《宣言》提到,目前較大的安全風險出現在人工智能的“前沿”領域,即前沿AI(Frontier Artificial Intelligence),也就是那些能力強大的通用人工智能模型,包括可以執行各種任務的基礎模型,以及特定的弱人工智能(narrow AI),兩者都具有給人類社會帶來傷害的能力。

如果上述前沿AI被故意濫用,或者在正當的使用過程中出現意外失控,都將會帶來巨大風險。《宣言》認爲,出現這些問題的部分原因是人們對這些前沿AI的能力還不完全瞭解,因此難以預測。

《宣言》尤其關注網絡安全和生物技術等領域的風險,以及前沿AI可能放大虛假信息等風險。鑑於人工智能發展速度之快和巨大的不確定性,以及在相關投資加速的背景下,《宣言》強調加深對這些潛在風險的理解,以及應對這些風險的行動尤爲迫切。

在接受第一財經採訪時,倫敦國王學院教授、人工智能研究所所長卡邁恩·文特爾(Carmine Ventre)稱,弱人工智能解決的是特定任務,如果落入壞人之手,可能會產生極爲危險的後果,比如,“爲生物工程應用而設計的人工智能模型,可能會被用來製造生物武器”。

加大投入應對AI風險

“前沿人工智能模型的威力正在呈指數級增長。”英國首相里希·蘇納克在社交媒體發文表示。

一年前的11月,當微軟支持的人工智能初創公司OpenAI向公衆開放ChatGPT聊天機器人應用時,人們開始擔心人工智能可能對經濟和社會產生的巨大影響。

英國在峯會上宣佈將增加對兩臺超級計算機的資助,以支持先進人工智能模型安全的研究。其中一臺超級計算機位於劍橋,由戴爾交付,包含超過1000個英特爾芯片;另一臺位於布里斯托爾,由HPE製造,包含5000個英偉達先進人工智能芯片。

兩臺機器將從明年夏天開始運行,並推動藥物發現和清潔能源方面的突破。

英國政府還表示,在人工智能研究方面的資金投入將從之前宣佈的1億英鎊增加到3億英鎊(約合27億元人民幣)。

美國政府利用此次峯會宣佈將成立美國人工智能安全研究所,該研究所將評估AI的潛在風險。美國總統拜登於本週一簽署了一項行政命令,賦予美國政府對人工智能系統進行更大監督的權力。新成立的美國人工智能安全研究所將與國際同行機構共享信息併合作研究。

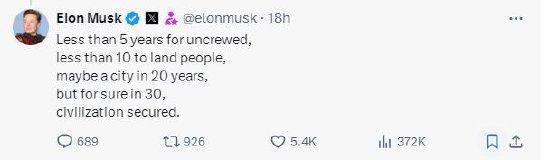

馬斯克呼籲引入“第三方裁判”

參加會議的還有埃隆·馬斯克和ChatGPT之父薩姆·奧爾特曼等科技大佬。科技高管和領導人警告稱,人工智能的快速發展如果不加以控制,將對世界構成生存威脅,各國政府和國際機構必須採取保障和監督措施。

目前針對人工智能大模型的發展主要存在兩派觀點:一派是以馬斯克爲代表的“風險警示者”,另一派是以谷歌、Meta等科技巨頭企業爲代表的“風險淡化派”。

馬斯克在會上呼籲,引入“第三方裁判”對人工智能的風險提出警告。他說道:“我不知道公平的規則到底是什麼,但在進行監督之前,你必須從洞察風險開始。”馬斯克還表示,他不認爲政府會在不知道該怎麼做之前就匆忙制定人工智能的監管規則。

谷歌旗下人工智能部門Deepmind聯合創始人穆斯塔法·蘇萊曼則認爲,當前的人工智能前沿模型不會造成任何“重大災難性危害”。但他表示,隨着行業訓練更大的模型,提前計劃風險的應對方式是有意義的。

牛津大學互聯網研究院(OII)互聯網研究教授、貝利奧爾學院研究員威廉·H·達頓(William H. Dutton)11月2日在參加於沙特首都利雅得舉辦的一場全球網絡安全論壇期間接受第一財經專訪時表示:“關於人工智能潛在風險的炒作非常多,但人們必須搞清楚到底何爲風險、何爲機會。這意味着我們需要更多的國際交流來了解人們對AI的想法。”

在談到馬斯克提出的在AI治理方面引入“第三方裁判”的措施時,達頓表示:“我認爲其中存在的問題是,這個裁判是否能夠公平地進行監督。”

學者呼籲建立國際監管機構

除了監管的必要性,《宣言》也高度強調了國際合作的重要性。《宣言》稱,由於人工智能產生的許多風險本身具有國際性,因此最好通過國際合作加以解決。

《宣言》建議,各國應考慮採取有利於創新、適度的治理和監管方法,最大限度地發揮人工智能的效益,並考慮到人工智能的相關風險;通過現有國際論壇和其他相關倡議,包括未來的國際人工智能安全峯會,加強和保持合作,並擴大與更多國家的合作,以確定、瞭解並酌情采取行動。

記者在峯會現場瞭解到,已有多位參加峯會的人工智能領域學者呼籲建立一個國際監管機構,監管人工智能的開發和應用,具體內容包括:對先進的人工智能系統進行強制註冊,開發時必須具備快速“關閉”功能,開發者必須將一定比例的研究預算用於確保人工智能安全。

此前亦有消息稱,英國政府對於本次峯會的目標之一,便是通過爲期兩天的峯會,呼籲各國合作,成立一個類似於政府間氣候變化專門委員會的人工智能專家監測小組。

卡邁恩·文特爾對此表示,決策者需要考慮到人工智能的特質,也就是發展方向的不確定性。他認爲,目前人工智能發展的速度遠超預期,因此,正在討論的法規和監管方式,應該是面向未來,並充分考慮到該領域的前沿研究。